Por cerca de un euro, se puede enviar una foto de cualquiera y el sistema devolverá una versión sin ropa. El canal, con más de 45.000 miembros, ya se ha usado para "desnudar" a más de 100.000 mujeres sin su consentimiento. Es una de las aplicaciones más perversas de esta forma de inteligencia artificial

En junio de 2019, Vice descubrió una inquietante aplicación que usaba inteligencia artificial (IA) para "desnudar" mujeres. Por 50 dólares (42,55 euros), DeepNude permitía a sus usuarios subir una foto de una mujer vestida y para recibir una foto de ella aparentemente desnuda. En realidad, el software utilizaba redes generativas antagónicas, el algoritmo de los deepfakes, para cambiar la ropa de las mujeres por cuerpos desnudos muy realistas. Cuanto más escasamente vestida aparecía la víctima, mejor. Y lo que es peor, no funcionaba en hombres.

En 24 horas, el artículo de Vice provocó tal rechazo que los creadores de la aplicación rápidamente la eliminaron. La cuenta de Twitter de DeepNude anunció que no se lanzarían otras versiones y que nadie más tendría acceso a esa tecnología.

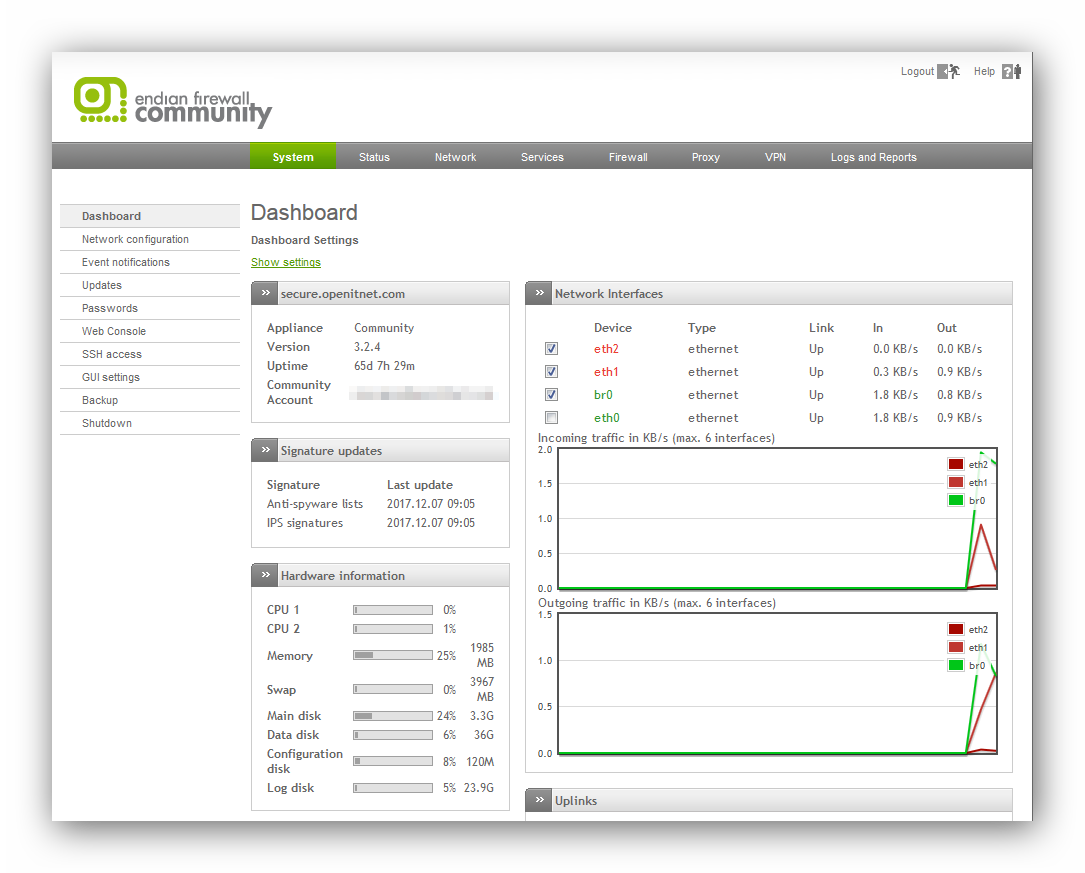

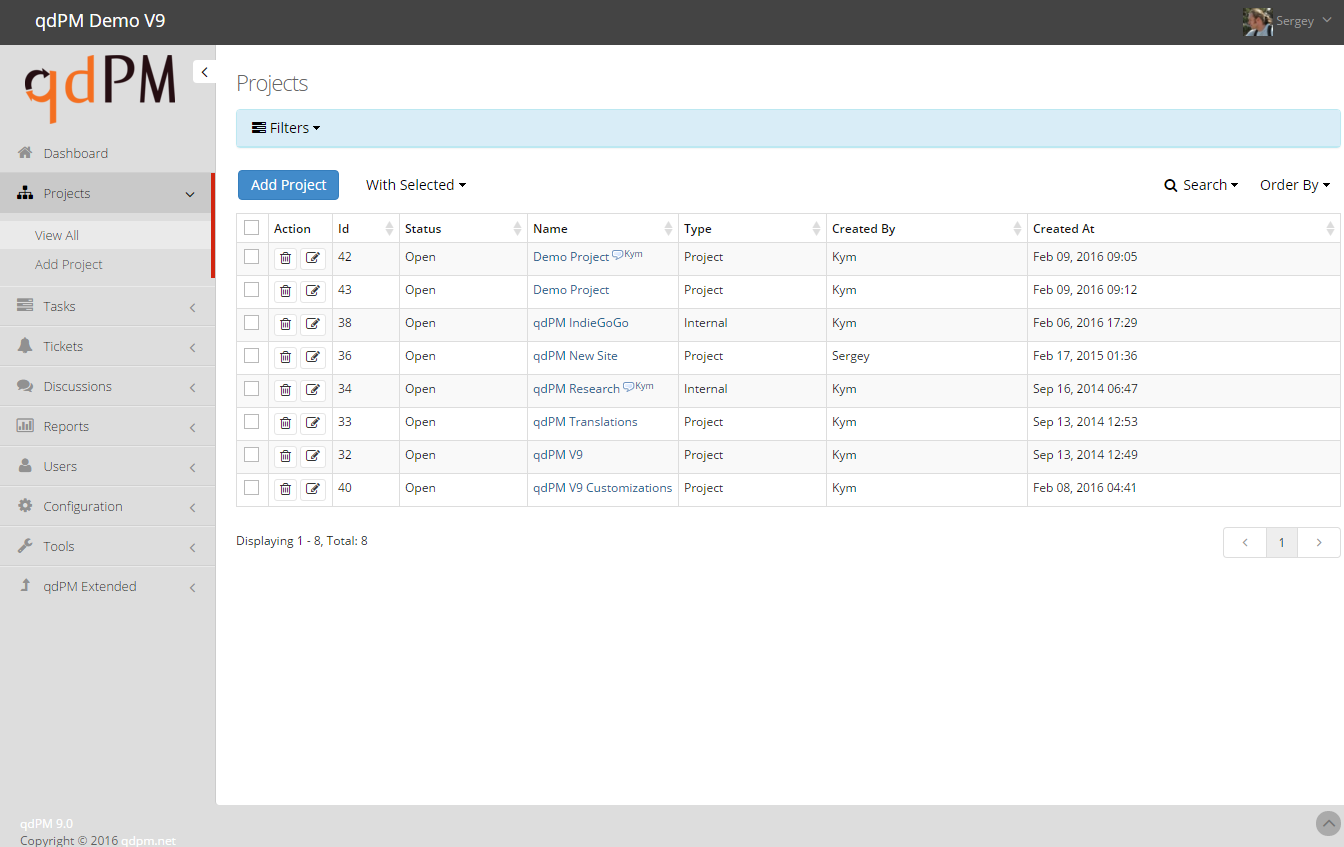

Pero una nueva investigación de la empresa de ciberseguridad Sensity AI (anteriormente Deeptrace Labs), enfocada en detectar abusos con contenidos manipulados, ha descubierto recientemente que un bot disponible públicamente está utilizando una tecnología muy similar en la aplicación de mensajería Telegram.

Esta vez la interfaz de usuario es aún más simple: cualquiera puede enviar una foto al bot a través de la aplicación móvil o web de Telegram y recibir la versión desnuda en unos minutos. El servicio es completamente gratuito, aunque los usuarios pueden pagar 100 rublos (aproximadamente unos 1,50 dólares o 1,28 euros) por funciones extra como quitar la marca de agua en las fotos "desnudas" o saltarse la cola de procesamiento.

En julio de 2020, este bot ya se había utilizado para "desnudar" al menos a 100.000 mujeres, la mayoría de las cuales probablemente no tenía ni idea de eso. "En general, se trata de mujeres jóvenes. Lamentablemente, a veces es bastante obvio que algunas de estas chicas son menores de edad", afirma el CEO y científico jefe de Sensity, Giorgio Patrini, quien fue coautor del informe.

Convertir el acoso en un juego

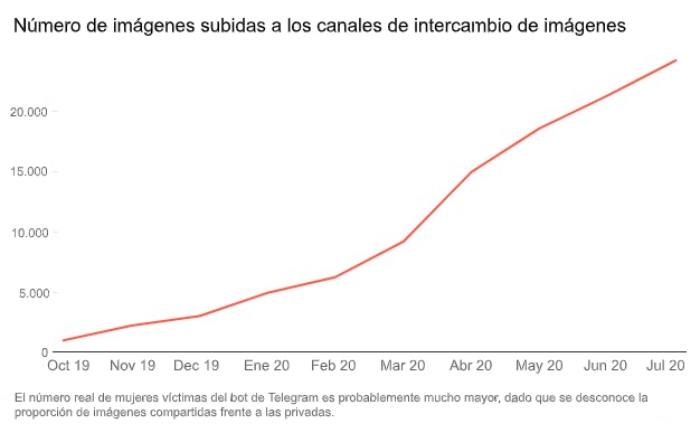

El bot deepfake, lanzado el 11 de julio de 2019, está conectado a siete canales de Telegram con un total de más de 100.000 miembros. (Este número no tiene en cuenta la membresía duplicada en los canales, pero solo el grupo principal tiene más de 45.000 miembros).

El canal central aloja el bot en sí, mientras que los demás se utilizan para funciones como soporte técnico e intercambio de imágenes. Los canales para compartir las imágenes incluyen interfaces que las personas pueden usar para publicar y opinar sobre sus creaciones desnudas. Cuanto más me gusta recibe una foto, más recompensa obtiene su creador. Dicha recompensa se efectúa en forma de en tokens para acceder a las funciones premium del bot. "El creador recibe incentivos como si se tratara de un juego", explica Patrini.

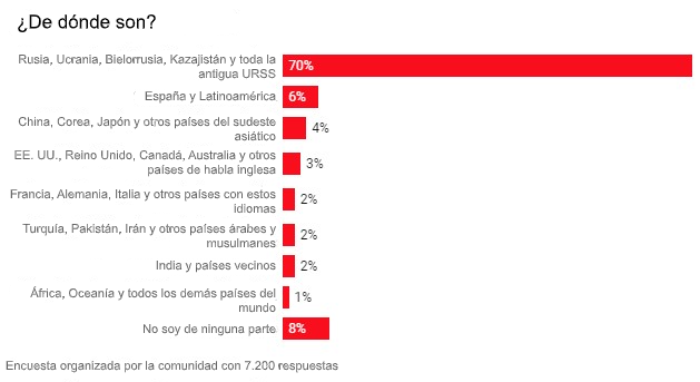

La comunidad, que se puede descubrir fácilmente a través de las búsquedas y las redes sociales, ha ido aumentando constantemente durante el último año. Una encuesta de 7.200 usuarios mostró que aproximadamente el 70 % de ellos son de Rusia u otros países de habla rusa. Sin embargo, las víctimas parece que provienen de distintos países, incluidos Argentina, Italia, Rusia y Estados Unidos.

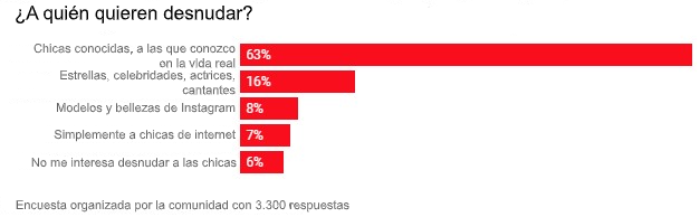

La mayoría de las mujeres son particulares a quienes los usuarios del bot afirman conocer en la vida real o haberlas encontrado en Instagram. Los investigadores pudieron solo identificar a un pequeño grupo de mujeres e intentaron contactarlas para comprender sus experiencias. Ninguna de las mujeres respondió, según Patrini.

Los investigadores también han contactado con Telegram y con las correspondientes agencias policiales, incluido el FBI. Telegram no respondió ni a su carta ni a la solicitud de comentarios de seguimiento de MIT Technology Review. Patrini afirma que tampoco han visto "ningún efecto tangible en estas comunidades" desde que se comunicaron con las autoridades.

Pornovenganza 'deepfake'

Los abusadores llevan bastante tiempo utilizando imágenes pornográficas para acosar a las mujeres. En 2019, un estudio de la Asociación Estadounidense de Psicología encontró que una de cada 12 mujeres acaba siendo víctima del porno vengativo en algún momento de su vida. Un estudio del Gobierno australiano, con datos de Australia, Reino Unido y Nueva Zelanda, encontró que la proporción llega a ser una de cada tres. La pornovenganza deepfake añade una dimensión completamente nueva al acoso, porque las víctimas ni siquiera saben que esas imágenes existen.

También hay muchos casos en los que se han utilizado deepfakes para acosar a famosas y otras personas de alto perfil. La tecnología se hizo popular por primera vez en los rincones oscuros de internet como forma de intercambiar las caras de personas famosas en vídeos porno, y se ha utilizado como parte de campañas de acoso para silenciar a mujeres periodistas.

Patrini resalta que también ha hablado con algunas influencers y YouTubers cuyas imágenes pornográficas falsas fueron enviadas directamente a sus patrocinadores, lo que les costó una inmensa tensión emocional y económica.

Patrini cree que estos ataques dirigidos podrían empeorar mucho. Sus compañeros investigadores y él ya han comprobado que la tecnología está evolucionando y expandiéndose. Por ejemplo, descubrieron otro ecosistema de más de 380 páginas dedicadas a la creación y el intercambio de deepfakes explícitos en la plataforma rusa de redes sociales VK. (Después de la publicación de este artículo, un portavoz de VK envió a MIT Technology Review una declaración: "VK no tolera este tipo de contenido o enlaces en su plataforma y bloquea las comunidades que los distribuyen. Realizaremos una verificación adicional y bloquearemos el contenido inapropiado y sus comunidades").

Los investigadores también han encontrado que el algoritmo para "desnudar" ha empezado a aplicarse a vídeos, como los de modelos en bikini caminando por una pasarela. Actualmente, el algoritmo debe aplicarse a cada fotograma, por lo cual "ahora mismo resulta muy rudimentario ", explica Patrini, y añade: "Pero estoy seguro de que la gente lo perfeccionará y también pondrá un servicio de licencias para eso".

Lamentablemente, todavía hay pocas formas de detener este tipo de actividad, pero la conciencia sobre el problema está aumentando. Empresas como Facebook y Google, y los investigadores que producen las herramientas para crear deepfakes han comenzado a invertir seriamente en contramedidas como la detección automatizada de deepfakes. El año pasado, el Congreso de Estados Unidos también presentó un nuevo proyecto de ley para crear un mecanismo para que las víctimas busquen recursos jurídicos por daños a su reputación.

Mientras tanto, Patrini señala que Sensity continuará rastreando e informando sobre este tipo de deepfakes maliciosos, y buscará más información sobre las motivaciones de quienes los crean y los impactos en las vidas de las víctimas. El responsable concluye: "De hecho, los datos que compartimos en este informe son solo la punta del iceberg".

Fuente: Technologyreview.es